WordPress robots txt находится в инструментах SEO оптимизации и применяется для настройки элементов вашего сайта подлежащих индексации поисковыми системами.

WordPress robots txt — это текстовый файл, расположенный в корне проекта, содержащий инструкции по индексации сайта. В robots txt прописывают всё что следует скрыть, указывают url главного зеркала и адрес XML карты сайта.

Правильно написанный robots txt положительно влияет на продвижение сайта, является хорошим тоном поисковой оптимизации и повышает доверие к сайту.

В этой статье мы рассмотрим, как сделать robots txt для WordPress, на базе плагина All In One SEO Pack.

Как сделать robots txt на WordPress

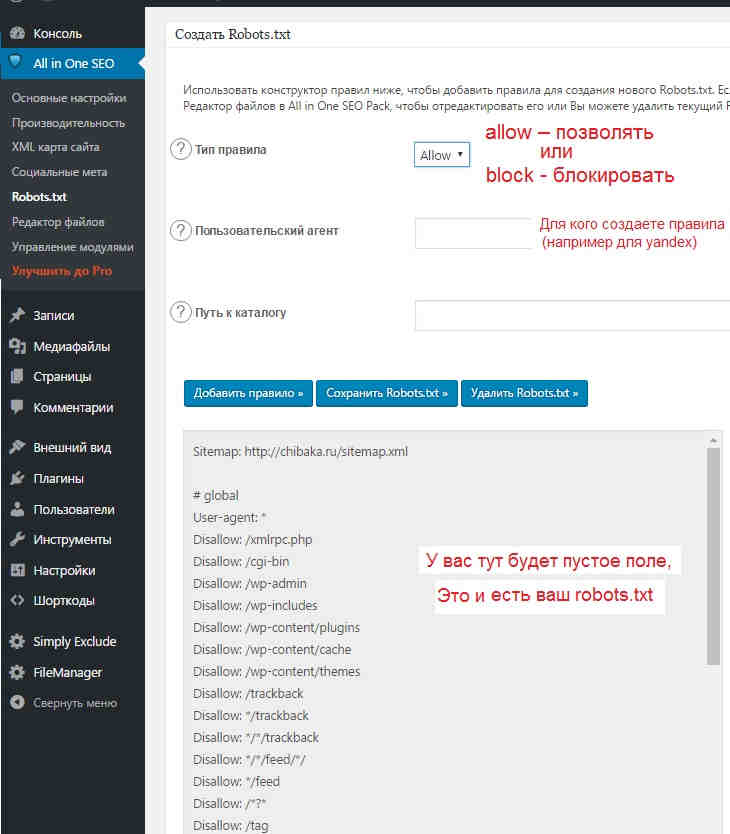

Чтобы создать robots.txt в WordPress установите плагин All In One SEO Pack, перейдите в меню управления модулями, выберите robots.txt и нажмите кнопку активировать, как показано на рисунке внизу.

Создать робота можно в любом окне интерфейса, но лучше в редакторе файлов.

Для создания robots.txt перейдите в редактор файлов и впишите все правила по очереди, с новой строки, без знаков препинания, а также адрес сайта и карты, после чего нажмите кнопку обновить.

Правильный robots txt для wordpress

Правильный robots txt для WordPress должен обеспечить качественный доступ к информации без дублирования ресурсов, показов черновиков, копий и скрытых частей сайта. Правильным роботом должны быть закрыты временный файлы, данные пользователей, политика конфиденциальности и другая информация неподлежащая публичной огласки.

Настройка robots txt

Настройку robots.txt лучше самому ни делать так-как в большей части он универсальный и подходит всем без исключения, а значит лучше взять готовый, сделанный спецами.